La récente décision de Mark Zuckerberg de supprimer les vérificateurs de faits des plateformes de Meta, notamment Facebook, Instagram et Threads, a suscité un débat houleux. Les critiques estiment que cette décision pourrait compromettre les efforts visant à lutter contre la désinformation et à maintenir la crédibilité des plateformes de médias sociaux.

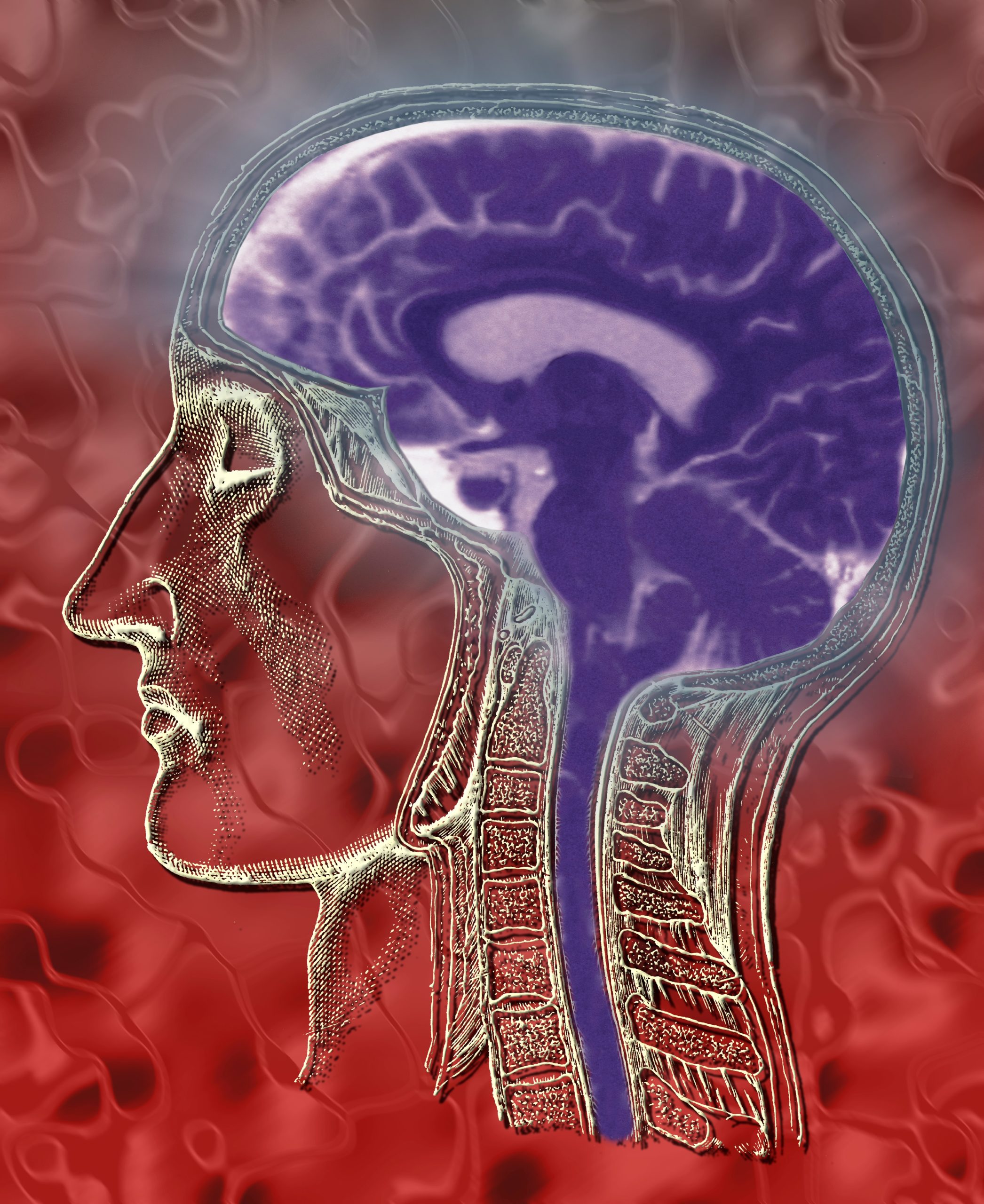

Pourtant, alors que cette évolution fait l’objet d’une attention particulière, un défi bien plus profond se profile à l’horizon. L’essor de l’intelligence artificielle (IA), qui traite et génère un langage proche de celui des humains, ainsi que des technologies qui visent à lire le cerveau humain , ont le potentiel de remodeler non seulement le discours en ligne, mais aussi notre compréhension fondamentale de la vérité et de la communication.

Les vérificateurs de faits jouent depuis longtemps un rôle important dans la lutte contre la désinformation sur diverses plateformes, en particulier sur des sujets tels que la politique, la santé publique et le changement climatique. En vérifiant les affirmations et en fournissant un contexte, ils ont aidé les plateformes à maintenir un certain degré de responsabilité.

La décision de Meta de les remplacer par des notes communautaires , à l’image de l’approche d’Elon Musk sur X (anciennement Twitter), a naturellement suscité des inquiétudes. De nombreux experts considèrent la décision de supprimer les vérificateurs de faits comme un pas en arrière , arguant que déléguer la modération du contenu aux utilisateurs risque d’amplifier les chambres d’écho et de permettre la propagation de faussetés incontrôlées.

Des milliards de personnes dans le monde utilisent chaque mois les différentes plateformes de Meta, ce qui leur confère une influence considérable. L’assouplissement des mesures de protection pourrait exacerber la polarisation sociale et saper la confiance dans la communication numérique.

Mais si le débat sur la vérification des faits fait la une des journaux, il y a une autre dimension à prendre en compte. Les modèles d’IA avancés comme ChatGPT d’OpenAI ou Gemini de Google représentent des avancées significatives dans la compréhension du langage naturel. Ces systèmes peuvent générer un texte cohérent et contextuellement pertinent et répondre à des questions complexes. Ils peuvent même engager des conversations nuancées. Et cette capacité à reproduire de manière convaincante la communication humaine présente des défis sans précédent.

Les contenus créés par l’IA brouillent la frontière entre la paternité humaine et la paternité machine. Cela soulève des questions éthiques sur la paternité, l’originalité et la responsabilité. Les mêmes outils qui alimentent des innovations utiles peuvent également être utilisés pour produire des campagnes de désinformation sophistiquées ou manipuler l’opinion publique.

Ces risques sont aggravés par l’émergence d’autres technologies. Inspirés par la cognition humaine, les réseaux neuronaux imitent la façon dont le cerveau traite le langage. Cette intersection entre l’IA et la neurotechnologie met en évidence le potentiel de compréhension et d’exploitation de la pensée humaine.

Conséquences de la décision de Meta

La neurotechnologie est un outil qui lit et interagit avec le cerveau. Son objectif est de comprendre comment nous pensons. Comme l’IA, elle repousse les limites de ce que les machines peuvent faire. Les deux domaines se chevauchent de manière puissante.

Par exemple, REM space, une start-up californienne, développe un outil qui enregistre les rêves. Grâce à une interface cerveau-ordinateur, il permet aux gens de communiquer par le biais de rêves lucides. Si cette idée semble passionnante, elle soulève également des questions sur la confidentialité mentale et le contrôle de nos propres pensées.

Parallèlement, les investissements de Meta dans les neurotechnologies, parallèlement à ses projets d’intelligence artificielle, sont également préoccupants. Plusieurs autres entreprises mondiales explorent également les neurotechnologies . Mais comment les données issues de l’activité cérébrale ou des modèles linguistiques seront-elles utilisées ? Et quelles mesures de protection empêcheront toute utilisation abusive ?

Si les systèmes d’IA peuvent prédire ou simuler les pensées humaines grâce au langage, la frontière entre communication externe et cognition interne commence à s’estomper. Ces avancées pourraient éroder la confiance, exposer les individus à l’exploitation et remodeler notre façon de penser la communication et la vie privée.

Les recherches suggèrent également que si ce type de technologie peut améliorer l’apprentissage, il peut également étouffer la créativité et l’autodiscipline, en particulier chez les enfants.

La décision de Meta de supprimer les vérificateurs de faits mérite d’être examinée de près, mais elle n’est qu’une partie d’un défi beaucoup plus vaste. L’IA et la neurotechnologie nous obligent à repenser la façon dont nous utilisons le langage, exprimons nos pensées et même comprenons le monde qui nous entoure. Comment pouvons-nous nous assurer que ces outils servent l’humanité plutôt que de l’exploiter ?

L’absence de règles pour gérer ces outils est alarmante. Pour protéger les droits humains fondamentaux, nous avons besoin d’une législation forte et d’une coopération entre les différents secteurs et gouvernements. Il est crucial de trouver cet équilibre. L’avenir de la vérité et de la confiance dans la communication dépend de notre capacité à relever ces défis avec vigilance et prévoyance.

Rédacteur Fetty Adler

Collaborateur Jo Ann

Auteurs

1. Fiona Carroll

Maître de conférences en interaction homme-machine, Université métropolitaine de Cardiff au Royaume-Uni.

2. Rafael Weber Hoss

Doctorant en technologies du renseignement et conception numérique, Université métropolitaine de Cardiff au Royaume-Uni.

Cet article est republié à partir du site The Conversation, sous licence Creative Commons

Soutenez notre média par un don ! Dès 1€ via Paypal ou carte bancaire.