Selon des documents judiciaires émanant du ministère de la justice des Émirats arabes unis, une banque s’est fait escroquer 35 millions de dollars suite à un appel téléphonique utilisant la technique de clonage vocal « Deep Voice », imitant la voix du directeur d’une société et client de cette banque.

Le 13 octobre, le ministère américain de la justice a déposé une demande d’ordonnance ex parte auprès de la Cour de district des États-Unis pour le district de Columbia, concernant une affaire de blanchiment d’argent survenue en janvier 2020 aux Émirats arabes unis.

Le dépôt, qui est peu détaillé, indique que le directeur d’une banque à Dubaï a reçu un appel téléphonique, qui pour lui, provenait d’un client, le dirigeant d’une société dont le nom n’est pas précisé, ainsi que plusieurs courriels provenant de ce même dirigeant et de l’avocat de sa société.

Le dirigeant a expliqué au directeur financier qu’il était sur le point de réaliser une acquisition commerciale et qu’il nécessitait un transfert de 35 millions de dollars, sur plusieurs comptes.

L’individu lui a dit qu’il avait engagé un avocat nommé Martin Zelner, basé aux Etats-Unis, pour coordonner les transactions, après quoi la banque a reçu plusieurs courriels de l’homme d’affaires présumé et de l’avocat confirmant le montant d’argent qui devait être déplacé.

Selon le rapport du ministère américain de la Justice, la voix à l’autre bout du fil provenait d’une technique de clonage vocal, connue sous le nom de « Deep Voice » utilisée pour simuler la voix du dirigeant de la société.

L’argent a été transféré sur des comptes bancaires de plusieurs pays « dans un schéma complexe, impliquant au moins 17 appelés, connus et inconnus. » Les enquêteurs des Émirats arabes unis ont découvert que deux transactions, totalisant un peu plus de 415 000 dollars, avaient transité via deux comptes de la Centennial Bank, basée aux États-Unis.

La demande vise à contraindre la Centennial à fournir « les dossiers et informations bancaires » relatifs aux transactions.

Selon un article de Forbes du 14 octobre, le ministère public de Dubaï, ainsi que l’avocat Martin Zelner, n’ont pas répondu aux demandes de la presse dans cette affaire.

En 2019, le Wall Street Journal a fait état d’un cas identique où la « Deep Voice » a été utilisée pour simuler la voix du PDG d’une entreprise allemande, demandant au responsable d’une filiale au Royaume-Uni de virer 220 000 euros à un fournisseur hongrois, en déclarant que c’était urgent et que le transfert devait traité dans l’heure.

Selon le Journal, le dirigeant trompé pensait avoir reconnu le léger accent allemand et la mélodie de la voix de son patron au téléphone.

L’article indique que les fraudeurs sont devenus gourmands en cherchant à porter le coup de grâce : « Les attaquants responsables de l’escroquerie de la société d’énergie britannique ont appelé trois fois… Après le transfert des 243 000 dollars, les pirates ont appelé pour dire que la société mère avait transféré de l’argent pour rembourser la société britannique. »

« Ils ont ensuite passé un troisième appel plus tard dans la journée, en se faisant à nouveau passer pour le PDG, et ont demandé un deuxième paiement. Comme le virement remboursant les fonds n’était pas encore arrivé et que le troisième appel provenait d’un numéro de téléphone autrichien, le cadre s’est méfié. Il n’a pas effectué le second paiement. »

Une tendance déformante

Les « Deep fakes » (vidéos ou un enregistrements audio produits ou modifiés grâce à l’intelligence artificielle) sont de plus en plus fréquentes. En août, le Centre for Information Resilience (CIR) a publié un rapport montrant comment le Parti communiste chinois (PCC) avait utilisé un botnet de faux comptes Twitter, en langue chinoise et anglaise, pour déployer son influence sur des thèmes comme la persécution des musulmans ouïghours, la pandémie de coronavirus 2019 et la question du contrôle des armes à feu et de la justice raciale aux États-Unis.

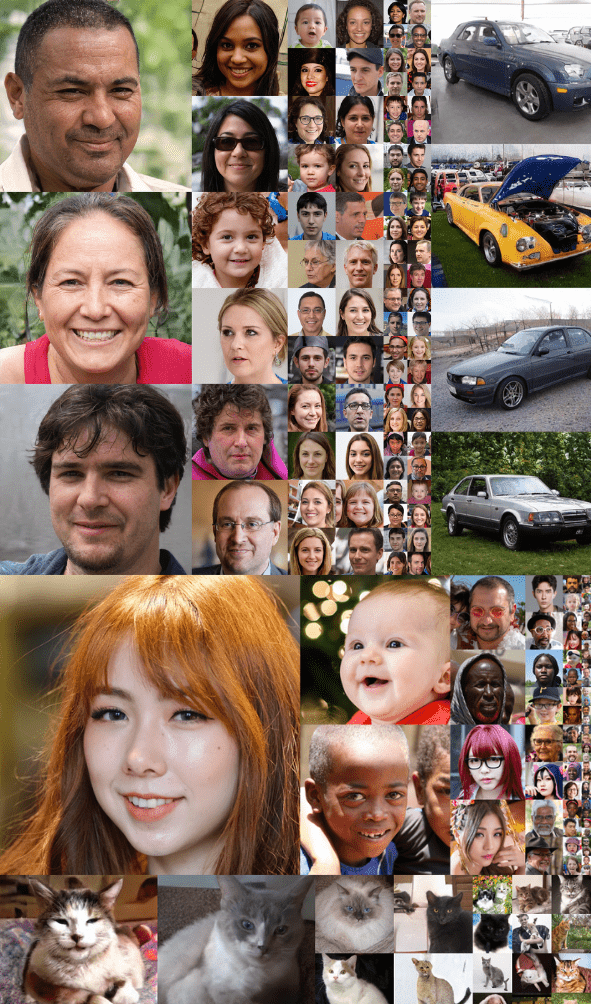

Les chercheurs ont constaté que l’une des révélations les plus récurrentes concernait l’utilisation de photos de profil créées par le réseau StyleGAN (Generative Adversarial Networks). Le fait que sur chaque photo, les yeux soient toujours sur le même axe horizontal est l’un des signes les plus évidents que les photos ont été créées par StyleGAN et qu’elles ne représentent pas de vrais humains, un fait rendu clair au fur et à mesure que le rapport soutenait sa thèse.

En mars, le compte @deeptomcruise sur TikTok a publié trois vidéos utilisant une technologie de « deep fake » générée par l’IA et montrant la star hollywoodienne maniant un club de golf, faisant un tour de magie et parlant de sa rencontre avec Mikhaïl Gorbatchev.

Les clips semblaient très convaincants. Les seuls indices mettant en doute leur authenticité ont été découverts au cours d’une analyse minutieuse de la vidéo au ralenti, qui montrait que les lunettes de soleil du faux personnage avaient disparu de quelques images après avoir été déplacées devant sa tête.

La guerre cognitive

Un rapport de novembre 2020 du Information Hub, intitulé Cognitive Warfare, se décrivant comme une étude parrainée par le NATO’s Allied Command Transformation (Commandement allié Transformation de l’OTAN), explique comment la nature de la technique consiste à éroder la confiance du public : « L’ingénierie sociale commence toujours par une plongée profonde dans l’environnement humain de la cible. L’objectif est de comprendre la psychologie des personnes ciblées. »

Le rapport poursuit : « Cette phase est plus importante que toutes les autres car elle permet non seulement de cibler précisément les bonnes personnes mais aussi d’anticiper les réactions, et de développer l’empathie. La compréhension de l’environnement humain est la clé pour établir la confiance qui conduira finalement aux résultats souhaités. »

« La guerre cognitive poursuit l’objectif de saper la confiance (confiance du public dans les processus électoraux, confiance dans les institutions, les alliés, les politiciens…) donc l’individu devient l’arme, alors que le but n’est pas d’attaquer ce que les individus pensent mais plutôt la façon dont ils pensent. »

« Elle a le potentiel de " détricoter " l’ensemble du contrat social qui sous-tend les sociétés », déclare l’auteur.

Rédacteur Fetty Adler

Soutenez notre média par un don ! Dès 1€ via Paypal ou carte bancaire.