Des chercheurs affirment aujourd’hui que la populaire plateforme d’intelligence artificielle ChatGPT est effectivement moins performante dans certaines tâches que lors de son lancement en novembre dernier, malgré les assurances de son développeur OpenAI.

Des chercheurs de Stanford et de Berkeley ont constaté que, sur une période de quelques mois seulement, GPT-3.5 et GPT-4 - les systèmes qui alimentent ChatGPT - ont produit des réponses avec un taux de précision en chute libre.

Les résultats, détaillés dans un article qui n’a pas encore fait l’objet d’une évaluation par les pairs, confirment ce que de nombreux utilisateurs de l’IA soupçonnaient depuis un certain temps.

Le déclin observé des performances de l’IA a incité Peter Welinder, président des produits d’OpenAI, à tenter de dissiper les rumeurs.

« Non, nous n’avons pas rendu GPT-4 plus stupide. Au contraire : nous rendons chaque nouvelle version plus intelligente que la précédente », a-t-il tweeté le 13 juillet, ajoutant : « hypothèse actuelle : lorsque vous l’utilisez plus intensivement, vous commencez à remarquer des problèmes que vous n’aviez pas vus auparavant ».

Peter Welinder a ensuite déclaré aux utilisateurs : « si vous avez des exemples où vous pensez qu’il a régressé, veuillez répondre à ce fil de discussion et nous enquêterons ». Il a également indiqué aux utilisateurs que la version gratuite, GPT-3.5, s’était également améliorée.

Une aggravation substantielle

Les chercheurs de Stanford et de Berkeley estiment toutefois que l’IA est moins performante qu’auparavant pour certaines tâches.

« Nous constatons que les performances et le comportement de GPT-3.5 et GPT-4 varient considérablement entre ces deux versions et que leurs performances sur certaines tâches se sont considérablement dégradées au fil du temps », ajoutant qu’ils remettent en question l’affirmation selon laquelle GPT-4 devient plus forte.

« Il est important de savoir si les mises à jour du modèle visant à améliorer certains aspects nuisent en fait à sa capacité dans d’autres dimensions », écrivent les chercheurs.

Les chercheurs, dont Lingjiao Chen, titulaire d’un doctorat en informatique, et James Zou, l’un des auteurs de l’étude, ont confié à l’IA une tâche relativement simple : identifier les nombres premiers.

Ils ont constaté qu’en mars de cette année, l’IA réussissait à identifier les nombres premiers dans 84 % des cas, mais qu’en juin de l’année suivante, sa capacité à identifier correctement les nombres premiers n’était plus que de 51 %.

Les chercheurs ont soumis à l’IA un total de huit tâches différentes et ont constaté que le GPT-4 s’est dégradé pour six d’entre elles, tandis que le GPT-3.5 s’est amélioré pour six d’entre elles, mais n’a toujours pas obtenu d’aussi bons résultats que son frère plus avancé, le GPT-4, pour toutes les tâches.

Ils ont également constaté qu’en mars, GPT-4 répondait à 98 % des questions qui lui étaient posées, mais qu’en juin, il ne répondait plus qu’à 23 % des requêtes, indiquant aux utilisateurs que leur demande était trop subjective et qu’en tant qu’IA, il n’avait pas d’opinion.

Dérive de l’intelligence artificielle

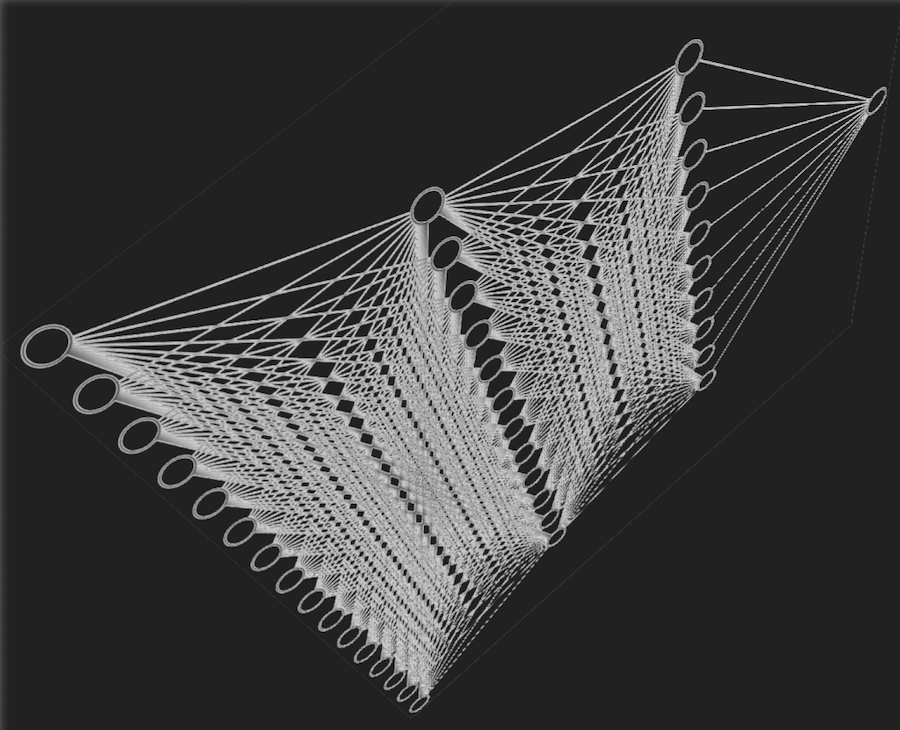

Les experts pensent que GPT-4 et 3.5, qui est la version gratuite, pourraient subir ce que les chercheurs appellent une « dérive de l’IA ».

La dérive se produit lorsque les grands modèles de langage (LLM) se comportent de manière étrange et s’éloignent des paramètres d’origine, ce qui déconcerte leurs développeurs.

Ce phénomène peut résulter de la mise en œuvre par les développeurs de modifications destinées à améliorer l’IA, mais qui finissent par avoir un impact négatif sur d’autres fonctionnalités.

Cela pourrait expliquer la détérioration des performances constatée par les chercheurs.

Par exemple, les chercheurs ont constaté qu’entre le mois de mars et le mois de juin suivant, GPT-4 avait de moins bonnes performances en matière de génération de code, de réponse à des questions d’examen médical et de réponse à des questions d’opinion, autant d’éléments qui peuvent être attribués au phénomène de dérive de l’IA.

James Zou a déclaré au Wall Street Journal : « nous soupçonnions que cela pouvait se produire ici, mais nous avons été très surpris par la rapidité avec laquelle la dérive se produit ».

Ces résultats pourraient permettre de mieux comprendre les performances d’autres plateformes d’IA sur de longues périodes. Selon les chercheurs, la dérive de l’IA est peut-être inévitable, car la plupart des LLM sont formés de la même manière et aboutissent donc à des résultats similaires.

Les auteurs de l’étude ont écrit qu’ils avaient l’intention de mettre à jour leurs résultats et de mener « une étude continue à long terme en évaluant régulièrement GPT-3.5, GPT-4 et d’autres LLM sur diverses tâches au fil du temps ».

Rédacteur Fetty Adler

Collaborateur Jo Ann

Source : You’re Not Imagining It: ChatGPT Is Getting Dumber and ’AI Drift’ May Be to Blame

Soutenez notre média par un don ! Dès 1€ via Paypal ou carte bancaire.