Comprendre comment notre cerveau organise les informations spatiales et y accède est un défi permanent pour les scientifiques. Pour savoir où nous sommes, ce qui nous entoure et comment nous déplacer dans notre environnement, il faut non seulement accéder aux données et aux souvenirs stockés dans le cerveau, mais aussi comprendre comment nos neurones s’assemblent pour effectuer des calculs complexes. Les systèmes d’apprentissages connus sous le nom de transformers pourraient améliorer notre compréhension du cerveau humain

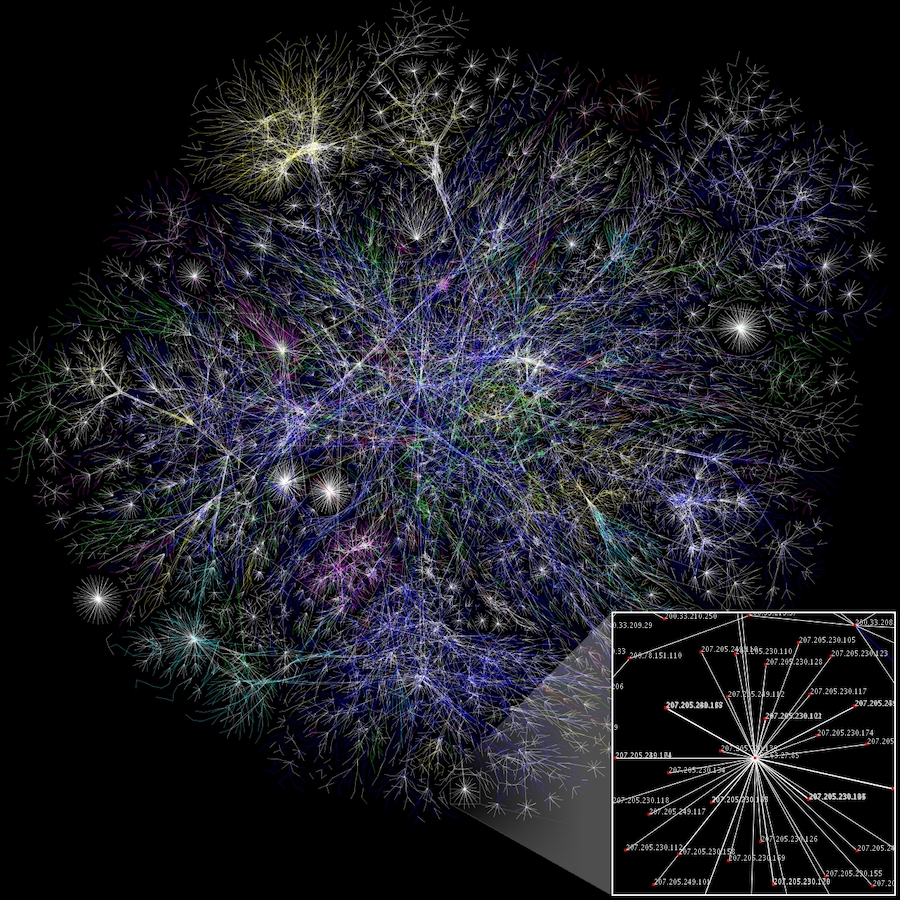

Comme nos milliards de cellules cérébrales sont connectées à des milliers d’autres, leur étude est beaucoup plus complexe que l’analyse des structures individuelles. Heureusement pour les neuroscientifiques qui sont constamment à la recherche de moyens de modéliser le fonctionnement du cerveau, l’intelligence artificielle pourrait permettre de mieux comprendre notre propre intelligence.

De nouvelles recherches montrent que les transformers, ces modèles d’apprentissage profond utilisés dans les systèmes automatisés peuvent nous aider à mieux comprendre les calculs effectués par nos propres réseaux neuronaux, et révéler des capacités inexploitées du cerveau.

Comment notre cerveau cartographie les lieux

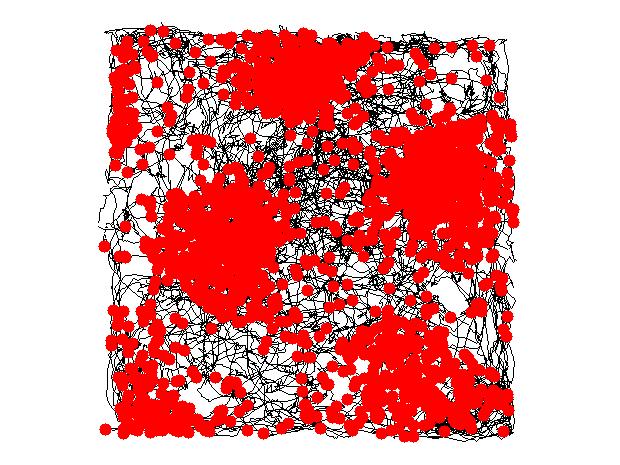

Une cellule de grille est un type de neurone présent dans le cerveau chargé de traiter et de stocker les informations relatives à la position d’une personne dans l’espace. Lorsque nous naviguons dans un espace ouvert, ces cellules cérébrales se déclenchent à intervalles réguliers pour intégrer les informations relatives à l’emplacement, à la distance et à la direction.

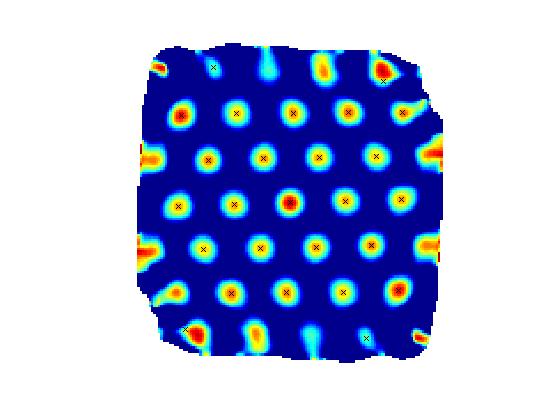

Situées dans l’hippocampe humain, les cellules de grille tirent leur nom du fait qu’en reliant les centres de leurs champs d’activation, on obtient une grille triangulaire. Il en résulte une sorte de motif en nid d’abeille qui occupe et définit. On pense que la disposition symétrique de ces cartes de « tirs neuronaux » est due aux efforts du cerveau pour créer une représentation cognitive des espaces perçus.

Une heureuse similitude entre l’hippocampe et les transformers

Dans leur quête d’optimisation des processus d’apprentissage automatique, les experts ont trouvé une similitude pratique dans la façon dont les transformers, ces modèles d’apprentissage profonds, et l’hippocampe, une structure cérébrale clé pour la mémoire, calculent les informations.

Contrairement aux autres réseaux neuronaux artificiels, qui traitent l’information sous la forme d’une séquence linéaire, les transformers peuvent traiter une entrée entière en une seule fois. En utilisant l’« auto-attention » (un mécanisme qui permet aux entrées individuelles d’interagir les unes avec les autres), ce modèle pondère l’importance de chaque partie des données d’entrée, ce qui lui permet de traiter un flux d’informations désordonné et de s’adapter à des entrées qui changent rapidement, ce que la plupart des IA ne peuvent pas faire.

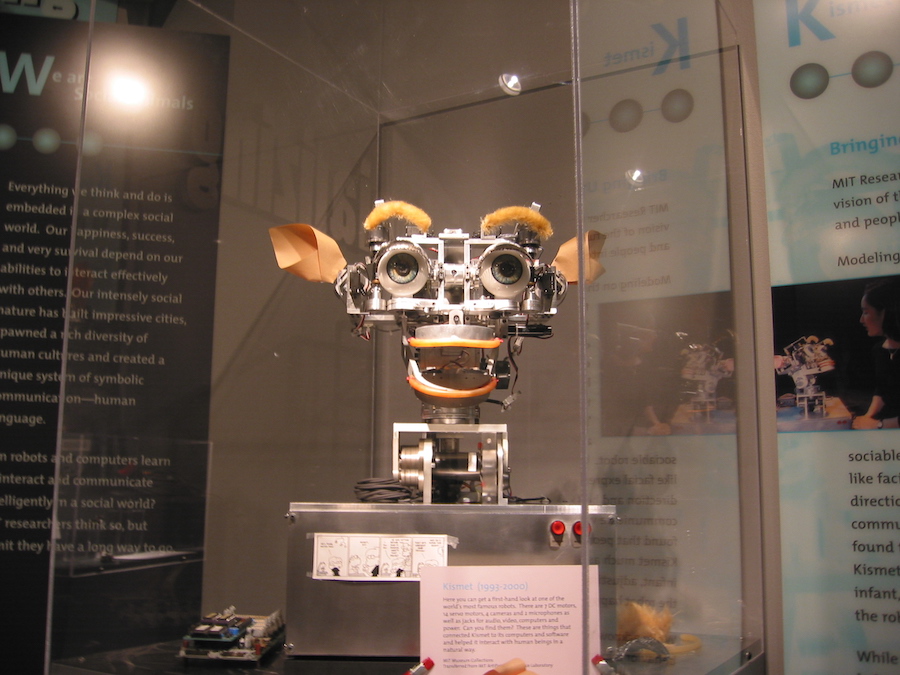

Les scientifiques pensent qu’en développant et en réoutillant les transformers, il serait possible de mieux comprendre le fonctionnement des réseaux neuronaux artificiels et, surtout, de saisir la complexité des calculs apparemment sans effort que le cerveau effectue à partir de données réelles.

Les transformers et leur principale application

Les transformers ont été développés pour la première fois en 2017 par une équipe de Google Brain, comme une nouvelle façon pour l’IA de traiter le langage. Ce qui a rendu ce modèle si innovant, c’est qu’au lieu de traiter une phrase comme une chaîne de mots, son mécanisme d’auto-attention pouvait fournir un contexte pour n’importe quelle position de la séquence d’entrée.

Concrètement, cela signifie que si une phrase en langage naturel comme un dicton ou une expression courante est reçue, le moteur la traite en une seule fois au lieu de donner un sens à un seul mot à la fois. Cela a permis d’optimiser le traitement du langage et de réduire les temps d’apprentissage de la machine.

Récupération de la mémoire

Depuis lors, les transformers ont été employés dans différents domaines avec beaucoup de succès. Une application remarquable a été proposée en 2020 par l’informaticien Sepp Hochreiter qui, avec son équipe de l’université Johannes Kepler de Linz (Autriche), a utilisé des transformers pour affiner un modèle de récupération de mémoire introduit il y a quarante ans, connu sous le nom de réseau de Hopfield.

Une fois les transformers incorporés au réseau de Hopfield, les scientifiques ont constaté que les connexions du mécanisme devenaient plus efficaces, ce qui lui permettait de stocker et de récupérer davantage de souvenirs par rapport au modèle standard. Le modèle a ensuite été amélioré en intégrant le mécanisme unique d’auto-attention des transformers dans le réseau de Hopfield lui-même.

Quand la symétrie naturelle devient une règle

Pour aller plus loin, les scientifiques ont tenté une approche différente au début de cette année. Ils ont modifié le transformer du réseau Hopfield de sorte qu’au lieu de traiter les souvenirs comme des ensembles linéaires de données, comme c’est généralement le cas avec le langage, il les codait comme des coordonnées dans des espaces de plus grande dimension.

Les chercheurs ont été fascinés par les résultats. Le modèle présenté par les coordonnées spatiales était mathématiquement équivalent aux modèles présentés par les cellules de grille dans l’hippocampe du cerveau. « Les cellules de grille ont ce genre de structure régulière, belle et excitante, avec des motifs frappants qui ont peu de chances d’apparaître au hasard », a expliqué Caswell Barry, chargé de recherche à l’University College de Londres (UCL).

Cette découverte laisse entrevoir le potentiel de l’IA pour nous aider à comprendre le corps humain, mais elle met également en évidence l’étonnante précision et les subtilités du cerveau que nous n’avons pas encore comprises. En fait, même les transformers les plus performants ne fonctionnent bien que pour les mots et les phrases courtes et sont loin d’égaler les capacités du cerveau à accomplir des tâches à plus grande échelle, comme la narration.

Bien que l’IA présente de nombreuses limites et suscite de graves inquiétudes quant à ses applications potentielles, son utilité pour nous aider à découvrir la profondeur des rouages miraculeux du cerveau humain pourrait être un pas dans la bonne direction.

Rédacteur Fetty Adler

Collaboration Jo Ann

Source : Transformers May Improve Our Understanding of the Human Brain

Soutenez notre média par un don ! Dès 1€ via Paypal ou carte bancaire.